Oracle y AMD anunciaron hoy una importante expansión de su colaboración de larga data y de múltiples generaciones para ayudar a los clientes a escalar significativamente sus capacidades e iniciativas de inteligencia artificial. Basándose en años de coinnovación, Oracle Cloud Infrastructure (OCI) será socio de lanzamiento del primer superclúster de IA disponible públicamente impulsado por las GPU AMD Instinct MI450 Series, con una implementación inicial de 50,000 GPU a partir del tercer trimestre de 2026 y una expansión prevista para 2027 y los años siguientes.

Este anuncio se basa en el trabajo conjunto de Oracle y AMD para ofrecer plataformas GPU AMD Instinct en OCI a clientes finales, comenzando con el lanzamiento de las shapes impulsadas por AMD Instinct MI300X en 2024 y extendiéndose a la disponibilidad general de OCI Compute con GPU AMD Instinct MI355X. Estas estarán disponibles en el supercluster OCI a escala zetta.

La demanda de capacidad de IA a gran escala sigue acelerándose, ya que los modelos de próxima generación superan los límites de los clústeres actuales. Para entrenar y ejecutar estas cargas de trabajo, los clientes necesitan soluciones de cómputo abiertas y flexibles, diseñadas para ofrecer un rendimiento y una eficiencia excepcionales a gran escala.

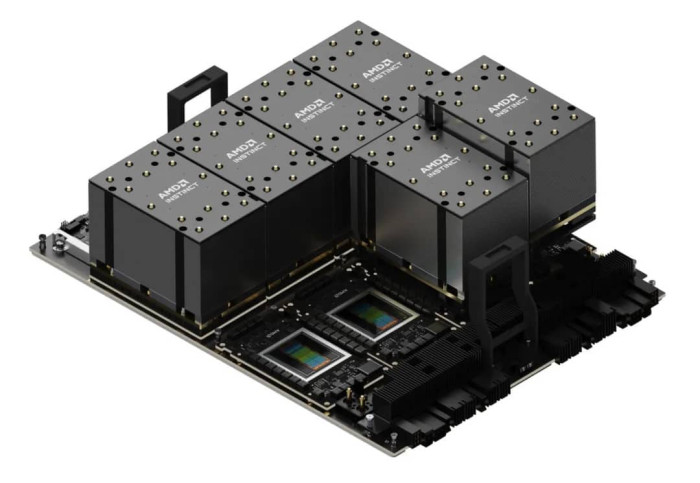

Los nuevos superclústeres de IA que OCI tiene previstos estarán impulsados por el diseño de rack AMD “Helios”, que integra las GPU AMD Instinct MI450 Series, los procesadores de próxima generación AMD EPYC, con nombre en código “Venice”, y la avanzada red AMD Pensando, con nombre en código “Vulcano”.

Esta arquitectura optimizada verticalmente, a nivel de rack, está diseñada para ofrecer el máximo rendimiento, escalabilidad y eficiencia energética en el entrenamiento e inferencia de IA a gran escala.

“Nuestros clientes están construyendo algunas de las aplicaciones de IA más ambiciosas del mundo, y eso requiere infraestructura robusta, escalable y de alto rendimiento”, dijo Mahesh Thiagarajan, vicepresidente ejecutivo de Oracle Cloud Infrastructure. “Al combinar las últimas innovaciones de los procesadores AMD con la plataforma segura y flexible de OCI y la avanzada conectividad de red impulsada por Oracle Acceleron, los clientes pueden superar límites con confianza. A través de nuestra colaboración de más de una década con AMD —desde EPYC hasta aceleradores AMD Instinct— seguimos ofreciendo el mejor precio-rendimiento, una base de nube abierta, segura y escalable en asociación con AMD para satisfacer las necesidades de esta nueva era de IA.”

“AMD y Oracle continúan marcando el ritmo de la innovación en IA en la nube”, dijo Forrest Norrod, vicepresidente ejecutivo y gerente general del Grupo de Soluciones para Centros de Datos de AMD. “Con nuestras GPU AMD Instinct, CPU EPYC y la avanzada conectividad de red AMD Pensando, los clientes de Oracle obtienen nuevas capacidades poderosas para entrenar, ajustar y desplegar la próxima generación de IA. Juntos, AMD y Oracle están acelerando la IA con sistemas abiertos, optimizados y seguros, construidos para centros de datos masivos de IA.”

“AMD y Oracle continúan marcando el ritmo de la innovación en IA en la nube”, dijo Forrest Norrod, vicepresidente ejecutivo y gerente general del Grupo de Soluciones para Centros de Datos de AMD. “Con nuestras GPU AMD Instinct, CPU EPYC y la avanzada conectividad de red AMD Pensando, los clientes de Oracle obtienen nuevas capacidades poderosas para entrenar, ajustar y desplegar la próxima generación de IA. Juntos, AMD y Oracle están acelerando la IA con sistemas abiertos, optimizados y seguros, construidos para centros de datos masivos de IA.”

GPU AMD Instinct MI450 Series llegan a OCI

GPU AMD Instinct MI450 Series llegan a OCI

Las shapes impulsadas por GPU AMD Instinct MI450 Series están diseñadas para ofrecer alto rendimiento, opciones de despliegue flexibles en la nube y soporte extensivo de código abierto. Esto proporciona la base ideal para clientes que ejecutan los modelos de lenguaje más avanzados, IA generativa y cargas de trabajo de cómputo de alto rendimiento. Con las GPU AMD Instinct MI450 Series en OCI, los clientes podrán beneficiarse de:

- Computación y memoria de vanguardia: Ayuda a los clientes a obtener resultados más rápidos, abordar cargas de trabajo más complejas y reducir la necesidad de particionar modelos al aumentar el ancho de banda de memoria para el entrenamiento de modelos de IA. Cada GPU AMD Instinct MI450 Series ofrecerá hasta 432 GB de HBM4 y 20 TB/s de ancho de banda de memoria, lo que permite a los clientes entrenar e inferir modelos un 50 % más grandes que las generaciones anteriores completamente en memoria.

- Diseño de rack “Helios” optimizado por AMD: Permite operar a gran escala optimizando densidad de rendimiento, costo y eficiencia energética mediante racks densos, refrigerados por líquido, con 72 GPU. Integra conectividad scale-up UALoE y redes scale-out basadas en Ethernet alineadas con el Consorcio Ultra Ethernet (UEC) para minimizar latencia y maximizar rendimiento entre pods y racks.

- Potente nodo principal: Maximiza la utilización del cluster y agiliza flujos de trabajo a gran escala acelerando la orquestación de trabajos y el procesamiento de datos con CPU AMD EPYC de próxima generación (“Venice”). Además, estos procesadores EPYC ofrecerán capacidades de confidential computing y funciones de seguridad integradas para proteger los workloads de IA sensibles de extremo a extremo.

- Red convergente acelerada por DPU: Permite ingestión de datos a velocidad de línea para mejorar rendimiento y seguridad en infraestructura de IA y nube a gran escala. Basada en la tecnología completamente programable AMD Pensando DPU, la red convergente acelerada por DPU ofrece la seguridad y el rendimiento necesarios para que los centros de datos ejecuten la próxima era de entrenamiento, inferencia y workloads de IA en la nube.

- Red scale-out para IA: Permite a los clientes aprovechar entrenamiento distribuido ultrarrápido y comunicación colectiva optimizada con una red abierta preparada para el futuro. Cada GPU puede equiparse con hasta tres AMD Pensando “Vulcano” AI-NICs de 800 Gbps, ofreciendo conectividad programable, sin pérdidas y de alta velocidad que soporta estándares avanzados RoCE y UEC.

- Innovador fabric UALink y UALoE: Ayuda a los clientes a expandir cargas de trabajo de manera eficiente, reducir los cuellos de botella de memoria y orquestar modelos grandes de múltiples trillones de parámetros. La arquitectura escalable minimiza saltos y latencia sin enrutar a través de CPUs, y permite networking coherente a nivel de hardware y compartición de memoria entre GPUs dentro de un rack mediante el protocolo UALink, transportado sobre el fabric UALoE. UALink es un estándar abierto de interconexión de alta velocidad diseñado específicamente para aceleradores de IA y respaldado por un amplio ecosistema industrial. Como resultado, los clientes obtienen la flexibilidad, escalabilidad y confiabilidad necesarias para ejecutar sus workloads de IA más exigentes en infraestructura basada en estándares abiertos.

- Stack de software AMD ROCm de código abierto: Permite una innovación rápida, ofrece libertad de elección de proveedor y simplifica la migración de workloads de IA y HPC existentes al proporcionar un entorno de programación abierto y flexible, incluyendo frameworks, librerías, compiladores y runtimes populares.

- Particionamiento y virtualización avanzada: Permite a los clientes compartir clústeres de manera segura y asignar GPUs según las necesidades de los workloads, facilitando el uso eficiente y seguro de los recursos mediante particionamiento fino de GPU y pods, virtualización SR-IOV y multi-tenancy robusto.